در دنیایی که سرعت پردازش اطلاعات هر روز اهمیت بیشتری پیدا میکند، کامپیوترهای کوانتومی و انقلاب در محاسبات در حال رقم زدن آیندهای هستند که تا چند سال پیش تنها در فیلمهای علمیتخیلی دیده میشد. این فناوری بر پایه اصول عجیب و شگفتانگیز فیزیک کوانتوم بنا شده است و میتواند محاسباتی را انجام دهد که حتی قدرتمندترین ابرکامپیوترهای جهان از عهدهاش برنمیآیند.

اما این تحول تنها محدود به ریاضیات یا فیزیک نیست؛ بلکه با ظهور هوش مصنوعی AI، ترکیب این دو فناوری به سرعت در حال تغییر چهره جهان است. از سایتهای هوش مصنوعی آنلاین گرفته تا صنایع داروسازی، امنیت سایبری و اقتصاد جهانی، همه در حال تجربهی انقلابی هستند که پایههای دنیای دیجیتال را از نو میسازد.

در این مقاله، از مفاهیم پایهای تا کاربردهای پیشرفته کامپیوترهای کوانتومی را بررسی میکنیم و خواهیم دید که چگونه این فناوری با استفاده از هوش مصنوعی آیندهی زندگی بشر را متحول میکند.

کامپیوتر کوانتومی چیست و چه تفاوتی با کامپیوترهای معمولی دارد؟

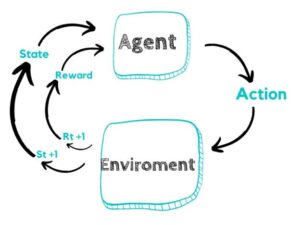

کامپیوترهای معمولی که هر روز از آنها استفاده میکنیم، مثل لپتاپ یا موبایل، اطلاعات را با صفر و یک (بیت) پردازش میکنند. اما کامپیوترهای کوانتومی از دنیای عجیبی به نام فیزیک کوانتوم الهام گرفتهاند. در این دنیای میکروسکوپی، ذرات میتوانند همزمان در چند حالت باشند. به همین دلیل، کامپیوتر کوانتومی قادر است چندین محاسبه را بهصورت همزمان انجام دهد.

برای مثال، اگر یک کامپیوتر معمولی در حل یک مسئله ریاضی چندین ساعت زمان نیاز دارد، یک کامپیوتر کوانتومی ممکن است همان مسئله را در چند ثانیه حل کند. شرکتهایی مانند IBM و Google نمونههای اولیه این سیستمها را ساختهاند. گوگل در سال ۲۰۱۹ اعلام کرد که با کامپیوتر کوانتومی خود، محاسبهای را انجام داده که قدرتمندترین کامپیوتر کلاسیک جهان نمیتواند در کمتر از ۱۰ هزار سال انجام دهد!

این قدرت باعث شده حتی در هوش مصنوعی و سایتهای هوش مصنوعی نیز به کامپیوترهای کوانتومی بهعنوان انقلابی در محاسبات نگاه شود؛ زیرا آنها میتوانند آموزش مدلهای هوش مصنوعی را میلیونها برابر سریعتر کنند.

مبانی فیزیک کوانتوم و نقش آن در دنیای محاسبات

فیزیک کوانتوم علمی است که رفتار ذرات بسیار کوچک مانند الکترونها و فوتونها را بررسی میکند. بر خلاف قوانین کلاسیک فیزیک نیوتونی، در جهان کوانتوم چیزها همیشه منطقی به نظر نمیرسند. مثلاً یک ذره میتواند همزمان در دو مکان باشد یا حتی با ذرهای دیگر در فاصله زیاد ارتباط داشته باشد.

کامپیوترهای کوانتومی از این ویژگیها برای انجام محاسبات پیچیده استفاده میکنند. بهطور خاص، پدیدههایی مانند درهمتنیدگی (Entanglement) و برهمنهی (Superposition) به آنها اجازه میدهد تا چندین حالت را همزمان پردازش کنند.

بهعنوان مثال، در هوش مصنوعی AI، زمانی که یک مدل باید میلیونها ترکیب داده را تحلیل کند، یک کامپیوتر کوانتومی میتواند تمام احتمالات را همزمان بررسی کند و سریعتر به بهترین نتیجه برسد.

این ویژگی باعث شده متخصصان به دنبال استفاده از هوش مصنوعی در کنار محاسبات کوانتومی باشند تا نسل جدیدی از فناوریها مانند پیشبینی آبوهوا، طراحی دارو و حتی رمزگشایی مولکولها ایجاد شود.

بیت در برابر کیوبیت (Qubit): قلب تپنده محاسبات کوانتومی

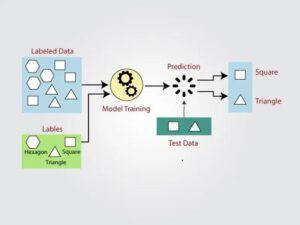

در کامپیوترهای معمولی، همه چیز بر پایه بیت (۰ و ۱) ساخته شده است. اما در کامپیوترهای کوانتومی، مفهومی جدید به نام کیوبیت (Qubit) وجود دارد. تفاوت اصلی در این است که کیوبیت میتواند بهطور همزمان هم ۰ باشد و هم ۱! این ویژگی که «برهمنهی» نام دارد، همان چیزی است که به کامپیوتر کوانتومی قدرت خارقالعاده میدهد.

برای مثال، اگر یک کامپیوتر کلاسیک بتواند فقط یک مسیر را در هر لحظه بررسی کند، یک کامپیوتر کوانتومی میتواند میلیونها مسیر را در همان لحظه تحلیل کند. شرکت Intel و Google در حال رقابت برای ساخت کیوبیتهای پایدارتر هستند تا خطاهای محاسباتی کاهش یابد.

در حوزه هوش مصنوعی آنلاین، کیوبیتها میتوانند روند آموزش مدلهای یادگیری عمیق را متحول کنند. مثلاً آموزش یک مدل زبانی بزرگ که روی سرورهای معمولی چندین هفته طول میکشد، با محاسبات کوانتومی ممکن است در چند ساعت انجام شود. این یعنی نسل آینده سایتهای هوش مصنوعی میتوانند با سرعت و دقتی بسیار بیشتر از امروز کار کنند.

چگونه کامپیوتر کوانتومی کار میکند؟ توضیح ساده برای همه

تصور کنید میخواهید کلید یک گاوصندوق را پیدا کنید و باید میلیونها حالت مختلف را امتحان کنید. یک کامپیوتر معمولی باید همه گزینهها را یکییکی تست کند، اما یک کامپیوتر کوانتومی میتواند همه حالات را همزمان بررسی کند و سریعتر به پاسخ درست برسد.

در واقع، این کامپیوترها با استفاده از پدیدههایی مانند برهمنهی و درهمتنیدگی، چندین محاسبه را بهطور همزمان انجام میدهند. البته کنترل این فرایند بسیار دشوار است، زیرا کوچکترین نویز محیطی میتواند باعث از بین رفتن حالت کوانتومی شود.

به همین دلیل، شرکتهایی مثل IBM Quantum در محیطهایی با دمای نزدیک به صفر مطلق (حدود منفی ۲۷۳ درجه سانتیگراد) کامپیوترهای کوانتومی خود را نگهداری میکنند.

چنین عملکردی باعث شده این فناوری در ترکیب با هوش مصنوعی AI، انقلابی در حل مسائل پیچیده مانند تحلیل دادههای بزرگ، طراحی دارو، و رمزنگاری ایجاد کند. در آینده، شاید استفاده از هوش مصنوعی در کنار قدرت محاسبات کوانتومی به استانداردی جدید در جهان فناوری تبدیل شود.

برتری کوانتومی (Quantum Supremacy) یعنی چه؟

عبارت برتری کوانتومی زمانی به کار میرود که یک کامپیوتر کوانتومی بتواند مسئلهای را حل کند که هیچ کامپیوتر کلاسیکی قادر به انجامش در زمان معقول نیست. این مفهوم در سال ۲۰۱۹ بهصورت رسمی مطرح شد، زمانی که شرکت Google AI Quantum اعلام کرد دستگاه ۵۴ کیوبیتی آن توانسته محاسبهای را در ۲۰۰ ثانیه انجام دهد که قدرتمندترین ابرکامپیوتر جهان برای آن به ۱۰ هزار سال نیاز داشت.

این نقطه، آغاز انقلاب کوانتومی بود. با رسیدن به برتری کوانتومی، شرکتها و دولتها بهسرعت سرمایهگذاری خود را افزایش دادند تا از مزایای این فناوری در زمینههایی مانند هوش مصنوعی آنلاین، تحلیل دادههای عظیم و حتی شبیهسازی مولکولها استفاده کنند.

برای مثال، اگر مدلهای زبانی امروزی (مثل ChatGPT) روی کامپیوترهای کوانتومی اجرا شوند، میتوانند حجم بسیار بیشتری از داده را در زمان کمتر پردازش کنند و کیفیت پاسخها چندین برابر شود.

در نتیجه، سایتهای هوش مصنوعی آینده نهتنها سریعتر بلکه بسیار دقیقتر و هوشمندتر خواهند بود.

تفاوت الگوریتمهای کلاسیک و کوانتومی در حل مسائل پیچیده

در کامپیوترهای کلاسیک، الگوریتمها باید هر مسیر ممکن را بهصورت مرحلهبهمرحله بررسی کنند. اما در کامپیوترهای کوانتومی، الگوریتمها از خاصیت «برهمنهی» و «درهمتنیدگی» استفاده میکنند تا چندین حالت را همزمان پردازش کنند. همین تفاوت باعث میشود سرعت حل مسائل پیچیده بهطرز باورنکردنی افزایش یابد.

برای مثال، الگوریتم معروف «شور» (Shor’s Algorithm) در محاسبات کوانتومی میتواند اعداد بسیار بزرگ را سریعتر فاکتور بگیرد، در حالی که همین کار برای کامپیوترهای کلاسیک ممکن است سالها طول بکشد. این موضوع اهمیت زیادی در رمزنگاری و امنیت دادهها دارد.

در حوزه هوش مصنوعی AI نیز الگوریتمهای کوانتومی میتوانند مدلهای یادگیری ماشین را با سرعت بالاتری آموزش دهند. امروزه شرکتهایی مانند IBM Quantum و Google AI در حال آزمایش ترکیب الگوریتمهای کوانتومی با یادگیری عمیق هستند تا کاربردهای جدیدی برای استفاده از هوش مصنوعی در تحلیل دادههای پیچیده و تصمیمگیری سریع ایجاد کنند.

کاربردهای واقعی کامپیوترهای کوانتومی در دنیای امروز

اگرچه هنوز در ابتدای راه هستیم، اما کامپیوترهای کوانتومی وارد مرحله کاربردی شدهاند. یکی از مهمترین کاربردها در حوزه هوش مصنوعی است، جایی که مدلهای یادگیری عمیق با کمک محاسبات کوانتومی میتوانند دادههای عظیم را سریعتر تحلیل کنند.

برای مثال، شرکت IBM از کامپیوترهای کوانتومی خود برای شبیهسازی مولکولهای دارویی استفاده میکند تا داروهای جدید با دقت بالاتری طراحی شوند. در حوزه مالی نیز، بانکها از این فناوری برای بهینهسازی سبد سرمایهگذاری استفاده میکنند.

همچنین سایتهای هوش مصنوعی آنلاین در آینده ممکن است از این قدرت برای ارائه خدماتی مثل پیشبینی بازار بورس، تشخیص زودهنگام بیماریها یا طراحی مواد جدید استفاده کنند.

به طور خلاصه، هرجا که حجم زیادی از داده وجود دارد و سرعت تصمیمگیری حیاتی است، کامپیوترهای کوانتومی و هوش مصنوعی AI میتوانند در کنار هم تحول ایجاد کنند.

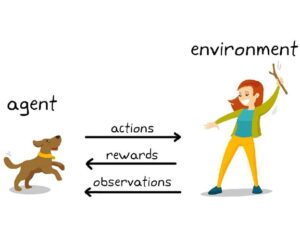

نقش کامپیوترهای کوانتومی در هوش مصنوعی و یادگیری ماشین

محاسبات کوانتومی میتواند بهعنوان شتابدهندهای برای هوش مصنوعی عمل کند. در مدلهای یادگیری عمیق، بخش زیادی از زمان صرف انجام محاسبات ماتریسی و پردازش دادهها میشود. اما با استفاده از کیوبیتها، این محاسبات میتوانند بهصورت همزمان انجام شوند.

برای مثال، پروژهی «Quantum AI» گوگل یکی از اولین تلاشها برای ترکیب این دو حوزه است. هدف آن است که یادگیری ماشین از سرعت و ظرفیت پردازش کوانتومی بهره ببرد.

در آینده، میتوان تصور کرد که سایتهای هوش مصنوعی آنلاین بتوانند دادههای کاربران را در لحظه تحلیل کرده و پاسخهایی بسیار دقیقتر ارائه دهند.

بهعنوان مثال، در پزشکی، ترکیب هوش مصنوعی AI و محاسبات کوانتومی میتواند الگوهای ژنتیکی را سریعتر تحلیل کند و بهترین درمان را پیشنهاد دهد. این یعنی ورود به عصری که استفاده از هوش مصنوعی دیگر محدود به دادههای کم و سختافزار کلاسیک نخواهد بود.

رمزنگاری و امنیت سایبری در عصر کوانتوم

یکی از حوزههایی که بیشترین تغییر را با ورود کامپیوترهای کوانتومی تجربه خواهد کرد، امنیت اطلاعات است. امروزه بیشتر سیستمهای رمزنگاری مانند RSA بر پایه دشواری فاکتورگیری اعداد بزرگ طراحی شدهاند. اما الگوریتمهای کوانتومی مانند Shor میتوانند این رمزها را در زمان بسیار کوتاهی بشکنند.

این موضوع باعث شده دانشمندان به دنبال طراحی رمزنگاری مقاوم در برابر کوانتوم (Post-Quantum Cryptography) باشند. شرکتهایی مانند IBM و Microsoft در حال کار روی این فناوری هستند تا امنیت اینترنت در عصر کوانتوم حفظ شود.

در همین راستا، هوش مصنوعی AI نقش مهمی در تشخیص حملات سایبری و طراحی سیستمهای دفاعی هوشمند دارد. ترکیب محاسبات کوانتومی و هوش مصنوعی میتواند در آینده امنیتی بیسابقه برای سایتهای هوش مصنوعی آنلاین و شبکههای جهانی ایجاد کند. به عنوان مثال، شبکههای بانکی میتوانند با این روش، تراکنشها را در لحظه رمزگذاری و بررسی کنند.

چالشهای فنی در ساخت و پایداری کامپیوترهای کوانتومی

با وجود تمام هیجان پیرامون انقلاب کوانتومی، ساخت یک کامپیوتر کوانتومی پایدار کار سادهای نیست. کیوبیتها به شدت حساساند و کوچکترین لرزش، تغییر دما یا میدان مغناطیسی میتواند حالت آنها را از بین ببرد. به همین دلیل، این سیستمها باید در دمایی نزدیک به صفر مطلق (حدود منفی ۲۷۳ درجه سانتیگراد) نگهداری شوند.

یکی از بزرگترین چالشها، «رفع خطاهای کوانتومی» است. حتی در پروژههای بزرگی مثل Google Sycamore و IBM Quantum, نرخ خطا هنوز بالاست.

مهندسان در تلاشاند تا با طراحی کیوبیتهای پایدارتر و استفاده از ابررساناها، این مشکل را کاهش دهند.

در عین حال، توسعه الگوریتمهای خاص برای هوش مصنوعی AI در محیطهای کوانتومی نیز نیازمند زمان و دانش تخصصی است. تا زمانی که این مشکلات حل نشود، شاید نتوانیم استفاده از هوش مصنوعی بر پایهی کوانتوم را در مقیاس عمومی ببینیم، اما روند پیشرفت بسیار سریع است و آیندهای درخشان در انتظار این فناوری است.

ابررساناها و دمای نزدیک به صفر مطلق؛ راز عملکرد کوانتومی

کامپیوترهای کوانتومی برای عملکرد دقیق خود نیاز به شرایطی بسیار خاص دارند. یکی از مهمترین این شرایط، دمای نزدیک به صفر مطلق است. در این دما، مواد خاصی به نام ابررساناها (Superconductors) به کار میروند که مقاومت الکتریکی آنها تقریباً صفر میشود. این ویژگی باعث میشود اطلاعات کوانتومی بدون نویز یا اتلاف انرژی منتقل شوند.

به عنوان مثال، در کامپیوتر کوانتومی شرکت IBM Quantum System One، کیوبیتها در دمای منفی ۲۷۳ درجه سانتیگراد نگهداری میشوند. این دمای فوقالعاده پایین باعث پایداری سیگنالهای کوانتومی میشود.

اگر این دما فقط چند درجه افزایش یابد، سیستم بهسرعت ناپایدار میشود.

در آینده، با پیشرفت فناوری، ممکن است بتوان از مواد جدیدی استفاده کرد که در دمای بالاتر هم خواص ابررسانایی داشته باشند. این مسئله میتواند مسیر را برای استفاده از هوش مصنوعی در پردازش دادههای کوانتومی هموار کند. تصور کنید سایتهای هوش مصنوعی آنلاین که امروز نیاز به ابررایانههای بزرگ دارند، در آینده با سختافزارهای کوانتومی کوچک اما فوقسریع کار کنند — تحولی که واقعاً انقلابی خواهد بود.

مقایسه برترین شرکتهای فعال در حوزه کامپیوتر کوانتومی (IBM، Google، Intel و…)

رقابت میان غولهای فناوری در زمینه کامپیوترهای کوانتومی به شدت داغ است. شرکت IBM از پیشگامان این حوزه محسوب میشود و با پلتفرم IBM Quantum Experience، امکان آزمایش الگوریتمهای کوانتومی را به صورت آنلاین برای پژوهشگران فراهم کرده است.

در مقابل، Google Quantum AI با سیستم Sycamore توانست در سال ۲۰۱۹ به «برتری کوانتومی» دست یابد. این دستاورد نقطهی عطفی در تاریخ محاسبات بود.

از سوی دیگر، شرکت Intel در حال توسعه تراشههای کوانتومی بر پایهی سیلیکون است که بتوانند با فناوریهای فعلی نیمههادی سازگار شوند.

این رقابت جهانی باعث رشد سریع این صنعت شده است. حتی شرکتهایی مانند Microsoft و Rigetti Computing نیز وارد میدان شدهاند و خدمات کوانتومی ابری ارائه میدهند.

با ترکیب این فناوریها با هوش مصنوعی AI، انتظار میرود نسل جدیدی از سایتهای هوش مصنوعی آنلاین شکل بگیرد که بتوانند با سرعتی بیسابقه دادهها را پردازش کنند. آینده محاسبات در دستان این شرکتهاست.

نقش چین و اروپا در رقابت جهانی کامپیوترهای کوانتومی

در حالی که ایالات متحده پیشتاز توسعه کامپیوترهای کوانتومی است، کشورهای دیگر مانند چین و کشورهای اروپایی نیز سرمایهگذاریهای گستردهای در این زمینه انجام دادهاند. چین توانسته یکی از پیشرفتهترین شبکههای ارتباط کوانتومی را بسازد و حتی ماهوارهای مخصوص انتقال دادههای کوانتومی به فضا بفرستد.

در اروپا، اتحادیه اروپا برنامهای به نام Quantum Flagship راهاندازی کرده است که با بودجه چند میلیارد یورویی به تحقیقات کوانتومی اختصاص دارد.

این سرمایهگذاریها نه تنها برای توسعه سختافزار بلکه برای هوش مصنوعی نیز حیاتی هستند، زیرا دادههای عظیمی که در پروژههای علمی تولید میشوند، باید بهصورت هوشمندانه تحلیل شوند.

ترکیب محاسبات کوانتومی و هوش مصنوعی AI میتواند به کشورهای مختلف کمک کند تا در زمینههایی مانند انرژی، سلامت و امنیت ملی پیشرفت چشمگیری داشته باشند.

در واقع، کشورهایی که امروز روی استفاده از هوش مصنوعی و فناوری کوانتوم سرمایهگذاری میکنند، فردا رهبران اقتصاد دیجیتال خواهند بود.

آینده شغلها در عصر کوانتوم؛ چه مهارتهایی موردنیاز خواهد بود؟

ورود کامپیوترهای کوانتومی دنیای کار را دگرگون خواهد کرد. همانطور که انقلاب دیجیتال شغلهای جدیدی مانند توسعهدهنده وب و متخصص داده ایجاد کرد، انقلاب کوانتومی نیز فرصتهای تازهای به وجود میآورد.

در آینده، نیاز زیادی به متخصصان علوم کوانتومی، هوش مصنوعی، رمزنگاری پیشرفته، و تحلیل دادههای کوانتومی وجود خواهد داشت. حتی مهندسان نرمافزار باید درک پایهای از الگوریتمهای کوانتومی و نحوه تعامل آنها با مدلهای هوش مصنوعی AI داشته باشند.

به عنوان مثال، شرکتهای بزرگی مانند Google و IBM هماکنون دورههای آموزشی رایگان درباره «برنامهنویسی کوانتومی» ارائه میدهند تا نیروی انسانی آینده را آماده کنند.

افرادی که بتوانند استفاده از هوش مصنوعی را با محاسبات کوانتومی ترکیب کنند، از ارزش بالایی در بازار کار برخوردار خواهند بود. این همان مسیری است که به ایجاد نسل جدیدی از سایتهای هوش مصنوعی آنلاین و استارتاپهای مبتنی بر فناوری کوانتوم منتهی میشود.

تأثیر انقلاب کوانتومی بر اقتصاد و صنایع بزرگ دنیا

تأثیر انقلاب کوانتومی تنها محدود به علوم کامپیوتر نیست؛ بلکه میتواند ساختار اقتصاد جهانی را نیز تغییر دهد. در صنایع داروسازی، شیمی، انرژی و مالی، محاسبات کوانتومی میتواند به بهینهسازی فرآیندها و کاهش هزینهها کمک کند.

به عنوان مثال، شرکتهای داروسازی با استفاده از کامپیوترهای کوانتومی و هوش مصنوعی AI میتوانند مولکولهای دارویی را شبیهسازی کنند و در زمان کوتاهتری داروهای جدید تولید نمایند. در صنعت مالی، الگوریتمهای کوانتومی میتوانند ریسک سرمایهگذاری را دقیقتر تحلیل کنند و سودآوری را افزایش دهند.

از سوی دیگر، سایتهای هوش مصنوعی آنلاین در حوزه تجارت الکترونیک یا خدمات ابری، میتوانند با استفاده از این فناوری، سرعت تحلیل دادهها و پیشنهاد محصولات را چندین برابر افزایش دهند.

به زبان ساده، هر صنعتی که با داده و تصمیمگیری سروکار دارد، از استفاده از هوش مصنوعی و محاسبات کوانتومی سود خواهد برد. آینده اقتصاد، اقتصادی هوشمند و کوانتومی است.

آیا کامپیوترهای کوانتومی جایگزین کامپیوترهای سنتی میشوند؟

پرسش بسیاری از مردم این است که آیا کامپیوترهای کوانتومی در آینده جایگزین کامپیوترهای معمولی خواهند شد؟ پاسخ کوتاه این است: نه کاملاً. این دو نوع فناوری در واقع مکمل هم هستند. کامپیوترهای کلاسیک در انجام وظایف روزمره مانند اجرای برنامهها، پردازش متن یا مدیریت دادهها بسیار کارآمدند. اما کامپیوترهای کوانتومی برای حل مسائل خاص و پیچیده طراحی شدهاند، مثل شبیهسازی مولکولها یا بهینهسازی در مقیاس بزرگ.

برای مثال، Google AI Quantum از سیستم Sycamore برای انجام محاسباتی استفاده میکند که حتی سریعترین ابرکامپیوترها از عهدهاش برنمیآیند. اما برای کارهای عادی همچنان از رایانههای کلاسیک استفاده میشود.

در واقع، آینده ترکیبی از هر دو خواهد بود. یعنی بسیاری از سایتهای هوش مصنوعی آنلاین و پلتفرمهای ابری از مدل هیبریدی استفاده خواهند کرد: بخشی از پردازشها بر روی سیستمهای کلاسیک و بخش دیگر بر روی سختافزارهای کوانتومی. این رویکرد باعث افزایش سرعت و دقت در استفاده از هوش مصنوعی و پردازش دادهها میشود.

چگونه کشورها در حال سرمایهگذاری بر روی فناوری کوانتوم هستند؟

در دهه اخیر، فناوری کوانتوم به یکی از حوزههای استراتژیک در جهان تبدیل شده است. کشورهایی مانند آمریکا، چین، آلمان، ژاپن و کانادا میلیاردها دلار در توسعه کامپیوترهای کوانتومی سرمایهگذاری کردهاند.

برای مثال، دولت چین پروژهای چند میلیارد دلاری برای ساخت شبکه ارتباط کوانتومی راهاندازی کرده است. در آمریکا نیز سازمانهایی مانند DARPA و NASA با همکاری شرکتهای خصوصی همچون IBM و Google، تحقیقات گستردهای در زمینه الگوریتمهای کوانتومی انجام میدهند.

اروپا نیز با برنامه Quantum Flagship، در تلاش است تا به رهبری جهانی در این حوزه برسد. این سرمایهگذاریها تنها به سختافزار محدود نمیشود، بلکه آموزش نیروی انسانی، توسعه نرمافزار و حتی همکاری با پروژههای هوش مصنوعی AI را نیز شامل میشود.

در آینده، کشورهایی که زودتر بتوانند استفاده از هوش مصنوعی را با محاسبات کوانتومی ترکیب کنند، در صنایع کلیدی مانند امنیت، انرژی و سلامت برتری چشمگیری خواهند داشت.

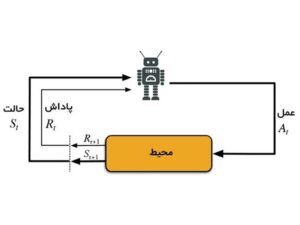

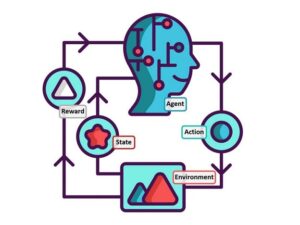

مفاهیم پیشرفته: درهمتنیدگی کوانتومی (Quantum Entanglement) و تداخل (Interference)

دو مفهوم کلیدی در دنیای کامپیوترهای کوانتومی، درهمتنیدگی و تداخل هستند.

درهمتنیدگی کوانتومی (Entanglement) زمانی رخ میدهد که دو یا چند ذره بهگونهای با یکدیگر ارتباط برقرار کنند که حالت یکی بر دیگری تأثیر بگذارد، حتی اگر فاصله زیادی بین آنها باشد.

تداخل (Interference) نیز به پدیدهای اشاره دارد که در آن امواج کوانتومی با هم ترکیب میشوند و برخی نتایج را تقویت یا حذف میکنند.

این دو ویژگی به کامپیوترهای کوانتومی اجازه میدهند میلیونها حالت احتمالی را همزمان بررسی کرده و به سریعترین پاسخ ممکن برسند.

برای مثال، در هوش مصنوعی AI، زمانی که یک مدل باید هزاران گزینه را برای تصمیمگیری بررسی کند، تداخل کوانتومی میتواند مسیر بهینه را در کسری از ثانیه بیابد.

هماکنون شرکتهایی مانند D-Wave از این مفاهیم برای ساخت سیستمهای تجاری کوانتومی استفاده میکنند. در آینده، ترکیب این مفاهیم با سایتهای هوش مصنوعی آنلاین میتواند توان محاسباتی آنها را به سطحی برساند که امروز حتی تصورش هم سخت است.

چشمانداز آینده؛ از اینترنت کوانتومی تا ارتباطات فراایمن

یکی از هیجانانگیزترین دستاوردهای آینده، اینترنت کوانتومی (Quantum Internet) است. در این نوع شبکه، دادهها نه از طریق امواج الکترومغناطیسی بلکه با استفاده از فوتونهای درهمتنیده منتقل میشوند. نتیجه؟ ارتباطاتی غیرقابل شنود و امنیتی تقریباً مطلق.

چین در این زمینه پیشگام است و اولین ماهواره ارتباط کوانتومی جهان به نام Micius را به فضا فرستاده است.

در چنین شبکهای، اگر فردی بخواهد داده را شنود کند، حالت کوانتومی ذرات تغییر میکند و سیستم فوراً متوجه نفوذ میشود.

این فناوری میتواند زیرساختی جدید برای هوش مصنوعی آنلاین و شبکههای ابری ایمنتر فراهم کند.

بهعنوان مثال، دادههای کاربران در سایتهای هوش مصنوعی میتوانند با رمزنگاری کوانتومی محافظت شوند تا حتی قدرتمندترین هکرها هم نتوانند به آن دسترسی پیدا کنند.

به این ترتیب، ترکیب هوش مصنوعی و محاسبات کوانتومی میتواند دنیایی با ارتباطات سریعتر و امنیت بالاتر خلق کند.

انقلاب کوانتومی و تأثیر آن بر زندگی بشر در دهه آینده

در نهایت، انقلاب کوانتومی تنها یک پیشرفت تکنولوژیک نیست، بلکه تغییری بنیادین در شیوهی زندگی انسانهاست. تصور کنید سیستمهای پزشکی بتوانند به کمک هوش مصنوعی AI و محاسبات کوانتومی بیماریها را پیش از بروز شناسایی کنند، یا شهرهای هوشمند بتوانند مصرف انرژی را با دقتی بیسابقه مدیریت نمایند.

در دهه آینده، انتظار میرود سایتهای هوش مصنوعی آنلاین با پشتیبانی از پردازش کوانتومی، خدماتی ارائه دهند که امروز غیرممکن به نظر میرسند — از تحلیل دقیق ژنوم انسان گرفته تا طراحی مواد جدید و حتی شبیهسازی جهانهای مجازی پیچیده.

هرچند هنوز چالشهای فنی و هزینههای بالایی وجود دارد، اما مسیر روشن است: آینده از آنِ هوش مصنوعی و کامپیوترهای کوانتومی است.

با ترکیب این دو فناوری، بشر به مرحلهای خواهد رسید که مرز میان علم و تخیل تقریباً از بین میرود. این همان انقلاب در محاسبات است که مسیر تمدن دیجیتال را برای همیشه تغییر خواهد داد.

سخن پایانی

فناوری کوانتوم دیگر صرفاً یک ایدهی علمی نیست؛ بلکه گامی واقعی بهسوی آیندهای هوشمندتر است. کامپیوترهای کوانتومی و انقلاب در محاسبات در کنار هوش مصنوعی AI میتوانند سرعت، دقت و امنیت را در سطحی بیسابقه افزایش دهند.

از شبیهسازی دارو و پیشبینی بازارهای مالی گرفته تا استفاده از هوش مصنوعی آنلاین در تحلیل دادهها، همهچیز در مسیر تحولی بنیادی قرار دارد.

البته مسیر پیش رو هنوز چالشهای فنی زیادی دارد؛ اما همانطور که اینترنت جهان را تغییر داد، فناوری کوانتوم نیز فصل جدیدی از تاریخ بشر را رقم خواهد زد — فصلی که در آن محاسبات، یادگیری و تصمیمگیری به شکل کوانتومی و فوقسریع انجام میشوند.