هوش مصنوعی در سالهای اخیر به یکی از مهمترین فناوریهای دنیا تبدیل شده و نقش آن در تحلیل داده، پیشبینی رفتار سیستمها و ساخت مدلهای هوشمند غیرقابل انکار است. در این میان، MATLAB بهعنوان یکی از قدرتمندترین ابزارهای مهندسی و علمی، جایگاه ویژهای در توسعه مدلهای هوش مصنوعی پیدا کرده است. ترکیب MATLAB با یادگیری ماشین، یادگیری عمیق، پردازش تصویر، پردازش سیگنال و سیستمهای کنترل هوشمند، آن را به ابزاری بیرقیب برای پژوهشگران و مهندسان تبدیل کرده است.

در این مقاله قصد داریم از پایه تا سطح پیشرفته، به بررسی کامل هوش مصنوعی با MATLAB بپردازیم؛ از تحلیل داده و پیشپردازش گرفته تا ساخت شبکههای عصبی عمیق و پیادهسازی مدلهای هوشمند در دنیای واقعی. اگر به دنبال یادگیری یا کاربرد حرفهای هوش مصنوعی هستید، MATLAB میتواند انتخابی ایدهآل باشد؛ زیرا علاوه بر ابزارهای آماده، محیطی یکپارچه، سریع و دقیق برای توسعه مدلها فراهم میکند.

چه کاربر مبتدی باشید و چه متخصص صنعتی، این مقاله به شما کمک میکند با قدرت MATLAB در دنیای هوش مصنوعی آشنا شوید و از آن در پروژهها، تحقیقات یا سایتهای هوش مصنوعی آنلاین نهایت استفاده را ببرید.

MATLAB چیست و چرا در هوش مصنوعی اهمیت دارد؟

MATLAB یک محیط برنامهنویسی قدرتمند است که در مهندسی، ریاضیات و تحلیل داده کاربرد گستردهای دارد. این نرمافزار با داشتن توابع پیشساخته، الگوریتمهای آماده و جعبهابزارهای تخصصی، یکی از بهترین پلتفرمها برای توسعه مدلهای هوش مصنوعی محسوب میشود. بسیاری از متخصصان، پژوهشگران و شرکتهای صنعتی از MATLAB برای پیادهسازی مدلهای یادگیری ماشین و یادگیری عمیق استفاده میکنند زیرا سرعت توسعه و دقت تحلیل در آن بسیار بالاست.

هوش مصنوعی با MATLAB به کاربران امکان میدهد دادههای پیچیده را تحلیل کنند، مدلهای دقیقتری بسازند و نتایج را به شکل گرافیکی نمایش دهند. برای مثال، یک مهندس میتواند با چند خط کد شبکه عصبی طراحی کرده و عملکرد آن را روی دادههای واقعی آزمایش کند. مزیت دیگر MATLAB، ارتباط آسان آن با زبانهایی مانند Python و C++ است که پیادهسازی مدلها را در دنیای واقعی سادهتر میسازد.

در سایتهای تخصصی هوش مصنوعی، MATLAB به عنوان یکی از ابزارهای استاندارد برای توسعه مدلها معرفی میشود و حتی برخی کاربران از نسخههای آنلاین آن برای اجرای سریع الگوریتمهای هوش مصنوعی استفاده میکنند. همین ویژگیها باعث شده MATLAB در حوزه هوش مصنوعی جایگاه ویژهای داشته باشد.

آشنایی با مفهوم هوش مصنوعی و نقش آن در تحلیل دادهها

هوش مصنوعی (Artificial Intelligence یا AI) مجموعهای از روشها و الگوریتمهاست که به ماشینها امکان یادگیری، تصمیمگیری و انجام کارهای مشابه انسان را میدهد. امروزه تقریباً همه صنایع از هوش مصنوعی برای تحلیل دادهها، پیشبینی روندها و بهبود فرآیندها استفاده میکنند. از فروشگاههای اینترنتی گرفته تا شرکتهای پزشکی و صنعتی، همگی از هوش مصنوعی آنلاین و آفلاین بهره میبرند.

تحلیل داده بخش جداییناپذیر AI است. یک سیستم هوش مصنوعی برای اینکه بتواند یاد بگیرد، ابتدا باید دادهها را پردازش کند. اینجاست که MATLAB وارد میدان میشود. MATLAB با امکانات قدرتمند تحلیل داده، ابزارهای آماری و الگوریتمهای پیشساخته، این امکان را میدهد که حجم زیادی از دادهها را بهسرعت تحلیل کنیم.

برای مثال، در یک سایت هوش مصنوعی، دادههای رفتار کاربران ذخیره میشود. با تحلیل این دادهها در MATLAB، میتوان الگوهای رفتاری کاربران را استخراج کرد، پیشبینی کرد چگونه رفتار خواهند کرد یا حتی پیشنهادهای شخصیسازیشده ارائه داد. نقش هوش مصنوعی با MATLAB بهویژه در حوزههایی مانند پزشکی (تحلیل تصاویر MRI)، اقتصاد (پیشبینی بازار)، و صنعت (کنترل هوشمند سیستمها) بسیار مهم است.

بهطور خلاصه، هوش مصنوعی قلب تحلیل دادههای مدرن است و MATLAB یکی از بهترین ابزارهای توسعه آن است.

چرا MATLAB یکی از بهترین ابزارها برای یادگیری ماشین است؟

MATLAB مجموعه کاملی از الگوریتمها، توابع و جعبهابزارهای آماده دارد که توسعه مدلهای یادگیری ماشین را ساده و سریع میکند. برخلاف بسیاری از زبانها که نیازمند کدنویسی طولانی و نصب کتابخانههای متعدد هستند، در MATLAB تنها با چند خط دستور میتوان یک مدل طبقهبندی، خوشهبندی یا رگرسیون ساخت.

یکی از دلایل محبوبیت MATLAB در سایتهای هوش مصنوعی، رابط کاربری گرافیکی (GUI) آن است. این رابطها به کاربر اجازه میدهند بدون کدنویسی پیچیده، دادهها را بارگذاری و مدلهای یادگیری ماشین را آموزش دهند. همچنین MATLAB امکانات قدرتمندی برای پیشپردازش دادهها، انتخاب ویژگی، تنظیم ابرپارامترها و تست مدلها در اختیار میگذارد.

برای مثال، یک متخصص میتواند دادههای پزشکی شامل فشار خون و ضربان قلب را وارد MATLAB کند و در چند دقیقه با استفاده از تابع fitcensemble یک مدل طبقهبندی برای تشخیص بیماری بسازد.

با توجه به اینکه هوش مصنوعی و یادگیری ماشین در سالهای اخیر رشد چشمگیری داشته، MATLAB توانسته جایگاه خود را بهعنوان یک ابزار استاندارد در دانشگاهها، صنعت و شرکتهای پیشرفته حفظ کند. امکانات MATLAB باعث شده استفاده از هوش مصنوعی بسیار سادهتر و دقیقتر شود.

آشنایی با محیط MATLAB و جعبهابزارهای کاربردی آن

محیط MATLAB شامل بخشهای اصلی مانند Command Window، Workspace، Editor و Figure است. این محیط کاربری ساده و حرفهای باعث میشود کاربران بهسرعت کدنویسی، تحلیل و نمایش نتایج را انجام دهند. MATLAB همچنین دارای جعبهابزارهای متعدد است که هر کدام برای یک حوزه تخصصی طراحی شدهاند.

برای مثال:

- Machine Learning Toolbox: ساخت مدلهای یادگیری ماشین

- Deep Learning Toolbox: طراحی شبکههای عصبی

- Computer Vision Toolbox: پردازش تصویر

- Statistics Toolbox: تحلیل آماری دادهها

این جعبهابزارها باعث شده MATLAB به یک انتخاب عالی برای کسانی باشد که به دنبال استفاده از هوش مصنوعی در پروژههای واقعی هستند.

یک مثال کاربردی: با استفاده از Computer Vision Toolbox میتوان یک برنامه تشخیص چهره طراحی کرد. کافی است تصاویر را بارگذاری کنید، ویژگیها را استخراج کنید و یک مدل یادگیری ماشین را آموزش دهید.

همچنین MATLAB نسخه آنلاین نیز دارد که کاربران بدون نصب نرمافزار میتوانند در محیط ابری، الگوریتمهای هوش مصنوعی را اجرا کنند. به همین دلیل سایتهای هوش مصنوعی اغلب MATLAB را برای افراد مبتدی و حرفهای توصیه میکنند.

ورود دادهها به MATLAB و روشهای پاکسازی و پیشپردازش آنها

اولین قدم در استفاده از هوش مصنوعی با MATLAB، ورود دادهها و آمادهسازی آنهاست. MATLAB امکان بارگذاری دادهها از منابع مختلف را فراهم میکند؛ مانند فایلهای Excel، CSV، پایگاههای داده SQL و حتی دادههای آنلاین. توابعی مثل readtable، csvread و xlsread از رایجترین ابزارهای ورود داده هستند. پس از وارد کردن دادهها، مرحله مهم بعدی پاکسازی (Data Cleaning) است.

در دنیای واقعی، دادهها معمولاً کامل و دقیق نیستند. ممکن است شامل مقدارهای گمشده، دادههای غیرعادی (Outliers)، تکراری یا فرمتهای ناسازگار باشند. MATLAB ابزارهای قدرتمندی برای مدیریت این مشکلات دارد. برای مثال، با دستور fillmissing میتوان مقدارهای خالی را بر اساس میانگین یا میانه پر کرد. همچنین تابع rmoutliers برای حذف دادههای غیرعادی استفاده میشود.

یک نمونه کاربردی: تصور کنید دادههای فروش یک فروشگاه اینترنتی را وارد MATLAB کردهاید. برخی روزها داده ثبت نشده یا مقدارهای عجیب وجود دارد. با استفاده از توابع پاکسازی، میتوان این دادهها را اصلاح کرد و سپس برای ساخت مدل هوش مصنوعی استفاده نمود.

پیشپردازش دادهها در MATLAB یکی از مهمترین مراحل توسعه مدلهای هوشمند است و بدون آن، حتی بهترین الگوریتمها نیز عملکرد مطلوبی نخواهند داشت. سایتهای هوش مصنوعی همیشه بر این مرحله تأکید دارند زیرا کیفیت دادهها مستقیماً روی دقت مدل تأثیر میگذارد.

تحلیل دادهها در MATLAB: از آمار توصیفی تا تحلیل اکتشافی

تحلیل دادهها (Data Analysis) یکی از پایههای اصلی استفاده از هوش مصنوعی محسوب میشود. در MATLAB ابزارهای متنوعی برای تحلیل آماری، مشاهده روندها و کشف الگوها وجود دارد. آمار توصیفی مانند میانگین، انحراف معیار، میانه و واریانس با توابع سادهای مثل mean، std و median بهسرعت محاسبه میشوند.

تحلیل اکتشافی (EDA) بخش عمیقتری از تحلیل دادههاست که با استفاده از نمودارها، جداول و الگوریتمهای ساده، به کشف الگوهای پنهان کمک میکند. توابعی مانند scatter، histogram، heatmap و boxplot ابزارهایی هستند که MATLAB برای بصریسازی اولیه دادهها فراهم میکند.

مثال کاربردی: فرض کنید دادههای مربوط به دمای یک کارخانه را در MATLAB بارگذاری کردهاید. با تحلیل اکتشافی، میتوانید تشخیص دهید آیا دما در برخی ساعات از روز افزایش غیرمعمول دارد یا خیر. این تحلیلها برای توسعه مدلهای هوش مصنوعی مانند سیستمهای هشدار هوشمند ضروری هستند.

در سایتهای هوش مصنوعی، MATLAB یکی از نرمافزارهای اصلی برای تحلیل دادهها معرفی میشود، زیرا امکان انجام تحلیلهای پیچیده را تنها با چند خط کد فراهم میکند. انجام درست EDA در MATLAB باعث میشود مدلهای یادگیری ماشین عملکرد دقیقتری داشته باشند.

آشنایی با جعبهابزار Machine Learning در MATLAB

جعبهابزار Machine Learning در MATLAB یکی از کاملترین ابزارها برای طراحی و آموزش مدلهای یادگیری ماشین است. این جعبهابزار شامل الگوریتمهایی مانند SVM، درخت تصمیم، رگرسیون خطی و لجستیک، KNN، Naive Bayes و مدلهای Ensemble است. نکته مهم این است که MATLAB همه این الگوریتمها را با طیف وسیعی از گزینهها ارائه میدهد تا کاربران بتوانند بهراحتی مدل مناسب را انتخاب کنند.

با استفاده از اپلیکیشن Classification Learner یا Regression Learner در MATLAB، کاربران حتی بدون کدنویسی نیز قادر به ساخت مدل هوش مصنوعی هستند. این ویژگی برای کسانی که از سایتهای هوش مصنوعی یا دورههای آموزشی شروع میکنند بسیار جذاب است.

یک مثال کاربردی: فرض کنید دادههای مربوط به تشخیص کیفیت محصولات در یک کارخانه را دارید. با استفاده از Classification Learner میتوانید مدل طبقهبندی ایجاد کنید که محصولات سالم و معیوب را از هم تشخیص دهد.

این جعبهابزار همچنین امکاناتی برای انتخاب ویژگیها، بررسی خطاها، نمایش نمودارهای عملکرد و بهینهسازی مدلها فراهم میکند. به همین دلیل MATLAB یکی از بهترین ابزارها برای استفاده از هوش مصنوعی در پروژههای صنعتی و دانشگاهی به شمار میرود.

ساخت اولین مدل یادگیری ماشین با MATLAB (طبقهبندی و رگرسیون)

ساخت یک مدل یادگیری ماشین در MATLAB بسیار ساده و سریع است. برای مثال، فرض کنید دادههایی شامل ویژگیهای قد و وزن دارید و میخواهید پیشبینی کنید آیا فرد دارای اضافهوزن است یا خیر. ابتدا دادهها را با استفاده از readtable وارد MATLAB میکنید، سپس آنها را به دو بخش آموزش و آزمون تقسیم میکنید.

برای ساخت مدل طبقهبندی، میتوان از تابع fitctree (درخت تصمیم) یا fitcsvm (ماشین بردار پشتیبان) استفاده کرد. تنها با چند خط کد مانند:

model = fitctree(X_train, y_train);

مدل شما آماده است. پس از آموزش مدل، با دستور predict میتوانید دادههای جدید را پیشبینی کنید.

در مسئله رگرسیون نیز میتوان از تابع fitlm (رگرسیون خطی) یا fitrgp (رگرسیون فرآیند گاوسی) استفاده کرد. مثلاً اگر بخواهید قیمت یک خانه را براساس مساحت و سال ساخت پیشبینی کنید، کافی است مدل را آموزش دهید و سپس دقت آن را بسنجید.

این فرایند ساده، MATLAB را به یک ابزار محبوب در سایتهای هوش مصنوعی تبدیل کرده است. بسیاری از کاربران برای یادگیری هوش مصنوعی آنلاین، MATLAB را به دلیل سادگی و امکانات گرافیکی پیشرفته انتخاب میکنند.

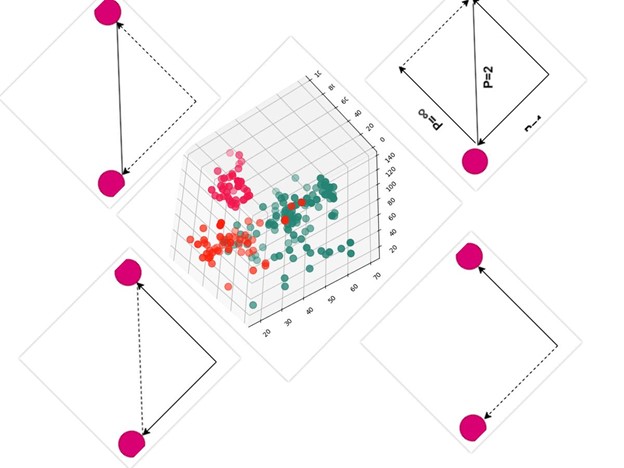

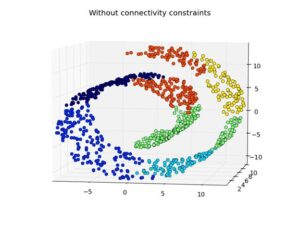

بصریسازی دادهها و نتایج مدلها در MATLAB

MATLAB یکی از قویترین ابزارها برای بصریسازی (Visualization) دادهها و نتایج مدلهای هوش مصنوعی است. نمودارهای دوبعدی و سهبعدی، نمودارهای حرارتی (Heatmap)، نمودارهای پراکندگی و نمودارهای تعاملی تنها بخشی از امکانات بصری MATLAB هستند.

بصریسازی برای متخصصان هوش مصنوعی اهمیت زیادی دارد زیرا کمک میکند الگوهای پنهان در دادهها دیده شوند و عملکرد مدلها بهتر ارزیابی شود. MATLAB توابعی مانند plot، scatter3، surf، histogram و confusionchart را برای نمایش نتایج مدلها ارائه میدهد.

یک مثال کاربردی: فرض کنید مدلی برای طبقهبندی ایمیلهای تبلیغاتی و معمولی ساختهاید. با استفاده از تابع confusionchart میتوانید ماتریس درهمریختگی مدل را مشاهده کنید و بفهمید مدل در کدام دستهبندیها اشتباه کرده است.

نمایش نتایج مدلها در MATLAB باعث میشود تصمیمگیری درباره بهبود الگوریتمها آسانتر شود. به همین دلیل بسیاری از سایتهای هوش مصنوعی، MATLAB را بهعنوان یک ابزار حرفهای بصریسازی دادهها معرفی میکنند.

بهینهسازی مدلها در MATLAB: انتخاب ویژگی تا تنظیم ابرپارامترها

بهینهسازی مدلهای هوش مصنوعی یکی از مهمترین مراحل توسعه سیستمهای هوشمند است. در MATLAB ابزارهای کاملی برای انتخاب ویژگی (Feature Selection)، کاهش ابعاد، و تنظیم ابرپارامترها (Hyperparameter Tuning) وجود دارد. بهینهسازی باعث میشود مدل سریعتر، دقیقتر و پایدارتر شود.

برای انتخاب ویژگی، MATLAB توابعی مانند fscchi2، fscmrmr و جعبهابزار Statistics را ارائه کرده است. این توابع کمک میکنند مهمترین ویژگیهای داده را پیدا کنیم. برای مثال، اگر دادههای پزشکی شامل ۳۰ ویژگی باشند، MATLAB میتواند مشخص کند کدام ۴ یا ۵ ویژگی بیشترین تأثیر را بر تشخیص بیماری دارند. این کار دقت مدل را افزایش میدهد و زمان محاسبات را کاهش میدهد.

تنظیم ابرپارامترها نیز بخش مهمی از بهینهسازی است. MATLAB با استفاده از روشهایی مانند Grid Search، Bayesian Optimization و Random Search، بهترین ترکیب پارامترها را برای مدل پیدا میکند.

مثال کاربردی: فرض کنید یک مدل SVM برای تشخیص دستخط ساختهاید. با استفاده از Bayesian Optimization در MATLAB میتوانید بهترین کرنل، C و گاما را انتخاب کنید تا مدل بیشترین دقت را داشته باشد.

به همین دلیل متخصصان و سایتهای هوش مصنوعی MATLAB را یکی از بهترین گزینهها برای بهینهسازی مدلها معرفی میکنند، زیرا این ابزارها بهصورت خودکار و حرفهای عمل میکنند.

جعبهابزار Deep Learning در MATLAB و معرفی شبکههای عصبی

جعبهابزار Deep Learning در MATLAB یکی از پیشرفتهترین ابزارهای توسعه شبکههای عصبی است و برای پروژههای حرفهای هوش مصنوعی کاربرد گستردهای دارد. این جعبهابزار امکان طراحی، آموزش و تست شبکههای مختلف را فراهم میکند؛ مانند CNN، LSTM، Autoencoder و GAN.

MATLAB این مزیت را دارد که بسیاری از لایههای شبکههای عصبی را بهصورت آماده در اختیار کاربر قرار میدهد. توابعی مانند convolution2dLayer، reluLayer، lstmLayer و fullyConnectedLayer تنها با یک خط کد قابل استفاده هستند. این موضوع طراحی مدلهای پیچیده را بسیار ساده میکند.

یک مثال کاربردی: فرض کنید میخواهید یک شبکه عصبی برای تشخیص ارقام دستنویس MNIST بسازید. کافی است شبکه CNN را با چند لایه کانولوشن، ReLU، MaxPooling و Fully Connected تعریف کنید. سپس با دستور trainNetwork مدل را آموزش دهید.

جعبهابزار Deep Learning همچنین به کاربران امکان میدهد از GPU برای افزایش سرعت آموزش استفاده کنند. همین قابلیت باعث شده MATLAB در سایتهای هوش مصنوعی بهعنوان یک ابزار حرفهای برای یادگیری عمیق معرفی شود، بهویژه برای کاربرانی که تجربه کمی در کدنویسی دارند اما میخواهند مدلهای پیشرفته بسازند.

ساخت شبکه عصبی عمیق در MATLAB با چند مثال کاربردی

ساخت شبکههای عصبی عمیق در MATLAB بسیار ساده و قدرتمند است. کاربران میتوانند تنها با چند خط کد، یک شبکه حرفهای ایجاد و آن را آموزش دهند. MATLAB از معماریهای مختلف مانند CNN، RNN، LSTM و شبکههای چندلایه پشتیبانی میکند.

مثال ۱ – تشخیص تصویر:

فرض کنید میخواهید یک مدل برای تشخیص گربه و سگ ایجاد کنید. ابتدا مجموعه تصاویر را با imageDatastore بارگذاری میکنید، سپس شبکهای شامل لایههای کانولوشن، ReLU، MaxPooling و Fully Connected میسازید. در نهایت با trainNetwork مدل را روی GPU آموزش میدهید.

مثال ۲ – پیشبینی سریهای زمانی:

اگر دادههای قیمت ارز دارید، میتوانید از شبکه LSTM برای پیشبینی آینده استفاده کنید. کافی است دادهها را نرمالسازی کنید، آنها را به sequence تبدیل کنید و شبکه را با lstmLayer طراحی کنید.

MATLAB ابزارهایی ارائه میدهد که ساخت مدل را برای همه افراد—even بدون تجربه عمیق در کدنویسی—تسهیل میکند. به همین دلیل، بسیاری از سایتهای هوش مصنوعی MATLAB را بهترین گزینه برای شروع یادگیری شبکههای عصبی میدانند.

MATLAB همچنین نسخه ابری دارد که امکان استفاده از هوش مصنوعی آنلاین را برای آموزش مدلها فراهم میکند.

تحلیل دادههای بزرگ (Big Data) با MATLAB

تحلیل دادههای بزرگ یا Big Data در دنیای امروز اهمیت بسیار زیادی دارد، زیرا سیستمهای هوشمند برای یادگیری نیاز به حجم عظیمی از دادهها دارند. MATLAB با داشتن ابزارهایی مانند tall arrays، mapreduce، distributed arrays و اتصال به Hadoop و Spark امکان تحلیل دادههای بزرگ را فراهم میکند.

tall array یکی از مهمترین قابلیتهاست؛ این ساختار داده حتی اگر فایلها چندین گیگابایت باشند، به MATLAB اجازه میدهد آنها را بهصورت بخشبخش پردازش کند بدون اینکه RAM سیستم پر شود.

برای مثال، اگر دادههای حسگرهای یک کارخانه را دارید که هر روز چند گیگابایت اطلاعات تولید میکند، MATLAB میتواند این دادهها را بخواند، تحلیل کند و مدلهای هوش مصنوعی بسازد.

μία مثال واقعی: با استفاده از mapreduce، میتوان محاسبات سنگین مانند میانگینگیری از میلیونها رکورد را در چند ثانیه انجام داد.

امروزه بسیاری از سایتهای هوش مصنوعی و شرکتهای صنعتی از MATLAB برای مدیریت Big Data استفاده میکنند زیرا ترکیب Big Data + AI یکی از نیازهای اصلی سیستمهای مدرن است.

استفاده از Parallel Computing برای سرعتبخشیدن به آموزش مدلها

Parallel Computing در MATLAB امکان پردازش چندوظیفهای و موازی را فراهم میکند، که باعث افزایش چشمگیر سرعت آموزش مدلهای هوش مصنوعی میشود. بسیاری از الگوریتمهای یادگیری ماشین و یادگیری عمیق به زمان زیادی برای آموزش نیاز دارند، بهویژه اگر حجم دادهها بزرگ باشد. MATLAB با Parallel Toolbox این مشکل را حل کرده است.

با استفاده از parfor، batch و parpool میتوان پردازشها را بین چندین هسته CPU یا حتی روی GPU تقسیم کرد. این قابلیت برای شرکتهایی که از هوش مصنوعی در پروژههای سنگین صنعتی استفاده میکنند بسیار ضروری است.

مثال کاربردی: فرض کنید مدلی دارید که باید روی ۱۰ هزار تصویر آموزش ببیند. در حالت عادی شاید چند ساعت طول بکشد، اما با فعالکردن Parallel Computing میتوانید آموزش را چند برابر سریعتر انجام دهید.

MATLAB همچنین امکان پردازشهای موازی در یادگیری عمیق را فراهم میکند، بهطوری که شبکههای CNN و LSTM میتوانند روی چندین GPU اجرا شوند. همین ویژگی باعث شده MATLAB در سایتهای هوش مصنوعی بهعنوان یکی از سریعترین پلتفرمهای آموزش مدل معرفی شود.

مدلسازی پیشبینی (Predictive Modeling) با MATLAB

مدلسازی پیشبینی یکی از کاربردهای مهم هوش مصنوعی در MATLAB است. این نوع مدلسازی به ما کمک میکند بر اساس دادههای تاریخی، رفتار آینده را پیشبینی کنیم. MATLAB با جعبهابزارهایی مانند Statistics و Machine Learning و همچنین مدلهای رگرسیون، درخت تصمیمگیری، SVM، شبکههای عصبی و روشهای Ensemble، مجموعه کاملی برای Predictive Modeling ارائه میدهد.

برای مثال، فرض کنید دادههای فروش یک فروشگاه اینترنتی را در اختیار دارید. با استفاده از رگرسیون خطی (fitlm) یا شبکه عصبی (trainNetwork) میتوانید پیشبینی کنید فروش ماه آینده چقدر خواهد بود. MATLAB امکان بررسی خطا، بهینهسازی مدل، و ارزیابی عملکرد را فراهم میکند تا بتوانید دقیقترین پیشبینی را داشته باشید.

یکی از مزیتهای MATLAB این است که میتواند دادهها را بهصورت خودکار نرمالسازی، پاکسازی و تحلیل کند و سپس براساس آنها مدل مناسب را پیشنهاد دهد. همین موضوع باعث شده MATLAB در سایتهای هوش مصنوعی یکی از برترین ابزارها برای مدلسازی پیشبینی معرفی شود.

Predictive Modeling با MATLAB برای حوزههایی مانند پزشکی (پیشبینی شدت بیماری)، صنعت (پیشبینی خرابی تجهیزات) و بانکداری (پیشبینی رفتار مشتریان) استفاده میشود و یکی از پایههای اصلی استفاده از هوش مصنوعی در دنیای واقعی است.

کاربرد MATLAB در هوش مصنوعی صنعتی و مهندسی

MATLAB یکی از قویترین ابزارها در صنعت و مهندسی است، بهخصوص زمانی که صحبت از هوش مصنوعی باشد. بسیاری از شرکتهای بزرگ صنعتی در بخشهایی مثل خودروسازی، نفت و گاز، هوافضا، انرژی و رباتیک از MATLAB برای تحلیل دادهها، کنترل سیستمها و ساخت مدلهای هوشمند استفاده میکنند.

برای مثال، در صنعت خودروسازی از MATLAB برای طراحی سیستمهای کمکراننده (ADAS)، تشخیص اشیاء در تصاویر، تحلیل عملکرد موتور، و پیشبینی خرابی قطعات استفاده میشود. در صنعت نفت و گاز نیز MATLAB برای تحلیل دادههای لرزهای و پیشبینی مخازن کاربرد دارد.

یک مثال کاربردی: در مهندسی کنترل میتوان از یادگیری ماشین در MATLAB برای تنظیم خودکار پارامترهای کنترلکننده PID استفاده کرد. این باعث میشود سیستم بدون دخالت انسان خود را با شرایط جدید سازگار کند.

MATLAB بهدلیل دقت بالا، ابزارهای حرفهای و توانایی پردازش دادههای پیچیده، در سایتهای هوش مصنوعی بهعنوان یکی از بهترین گزینهها برای پروژههای صنعتی معرفی میشود. استفاده از هوش مصنوعی در MATLAB روندهای صنعتی را هوشمندتر، سریعتر و ایمنتر کرده است.

کاربرد MATLAB در پردازش تصویر و بینایی ماشین

پردازش تصویر (Image Processing) و بینایی ماشین (Computer Vision) از مهمترین حوزههای هوش مصنوعی هستند. MATLAB یکی از کاملترین جعبهابزارهای پردازش تصویر را ارائه میکند. این جعبهابزار شامل توابعی برای فیلترگذاری، تشخیص لبه، بخشبندی تصاویر، استخراج ویژگیها و تشخیص اشیاء است.

برای نمونه، اگر بخواهید یک مدل هوش مصنوعی برای تشخیص پلاک خودرو بسازید، MATLAB ابزارهای لازم مانند edge، imread، regionprops و شبکههای CNN را فراهم میکند. همچنین Computer Vision Toolbox امکان پردازش ویدئو، ردیابی اشیاء، بازسازی سهبعدی، و تحلیل چهره را فراهم میسازد.

یک مثال کاربردی: برای تشخیص چهره، میتوان ابتدا ویژگیهای تصویر را با HOG استخراج کرد و سپس یک مدل طبقهبندی با SVM ساخت. یا میتوان از شبکههای عمیق مانند AlexNet و GoogLeNet استفاده کرد که در MATLAB بهصورت آماده در دسترس هستند.

سایتهای هوش مصنوعی MATLAB را یکی از بهترین گزینهها برای پردازش تصویر معرفی میکنند زیرا توسعه پروژهها در آن سریعتر و دقیقتر انجام میشود. بسیاری از شرکتهای صنعتی، آزمایشگاههای تحقیقاتی و دانشگاهها از MATLAB برای بینایی ماشین استفاده میکنند.

کاربرد MATLAB در پردازش سیگنال و صوت با مدلهای AI

پردازش سیگنال و صوت یکی از حوزههایی است که MATLAB بیشترین قدرت را دارد. ترکیب MATLAB با هوش مصنوعی باعث شده تحلیل و پیشبینی سیگنالها دقیقتر و هوشمندانهتر انجام شود. جعبهابزار Signal Processing و Audio Toolbox ابزارهای حرفهای برای تحلیل سیگنالهای زمان-فرکانس، فیلترگذاری، حذف نویز و استخراج ویژگیها ارائه میدهند.

برای مثال، اگر بخواهید یک سیستم تشخیص گفتار شبیه Siri یا Google Assistant بسازید، MATLAB میتواند ویژگیهایی مثل MFCC، طیفنگار (Spectrogram) و انرژی سیگنال را استخراج کرده و سپس با یک مدل CNN یا LSTM آموزش دهد.

یک مثال کاربردی دیگر: در پزشکی از MATLAB برای تحلیل سیگنال ECG استفاده میشود. مدلهای هوش مصنوعی میتوانند با تحلیل ریتم قلب، مشکلاتی مثل آریتمی را شناسایی کنند.

MATLAB همچنین ابزارهایی برای تحلیل سیگنالهای صنعتی مانند لرزش موتور، صوت توربین، و سیگنالهای حسگرهای IoT دارد. سایتهای هوش مصنوعی MATLAB را به دلیل دقت بالا در پردازش سیگنال و توانایی اتصال به سختافزارهای واقعی، یک انتخاب عالی برای مهندسان معرفی میکنند.

توسعه مدلهای هوش مصنوعی برای سیستمهای کنترل هوشمند

سیستمهای کنترل هوشمند ترکیبی از مهندسی کنترل و هوش مصنوعی هستند. MATLAB در این حوزه یک ابزار کاملاً تخصصی است زیرا Simulink و Control Toolbox را در کنار ابزارهای Machine Learning و Deep Learning ارائه میکند.

در سیستمهای کنترل سنتی، پارامترهای کنترلکننده باید دستی تنظیم شوند، اما با استفاده از هوش مصنوعی میتوان این تنظیمات را خودکار کرد. برای مثال، یک کنترلکننده PID میتواند با یک الگوریتم یادگیری تقویتی یا شبکه عصبی در MATLAB آموزش ببیند تا در شرایط مختلف بهترین عملکرد را ارائه دهد.

یک مثال کاربردی: در یک ربات صنعتی، شبکه عصبی میتواند بهصورت همزمان ورودیهای حسگرها را تحلیل کرده و سرعت و جهت حرکت را تنظیم کند. این کار با اتصال MATLAB به Simulink بسیار ساده میشود.

MATLAB همچنین امکان شبیهسازی کامل سیستمهای کنترل هوشمند را فراهم میکند، بدون اینکه نیاز به پیادهسازی واقعی روی سختافزار باشد. به همین دلیل در سایتهای هوش مصنوعی، MATLAB بهعنوان بهترین ابزار برای توسعه سیستمهای هوشمند معرفی میشود.

اتصال MATLAB به Python و استفاده همزمان از قدرت دو زبان در AI

یکی از قابلیتهای بسیار مهم MATLAB، امکان اتصال مستقیم به Python است. این ویژگی باعث میشود بتوانیم از قدرت هر دو زبان بهصورت یکپارچه در پروژههای هوش مصنوعی استفاده کنیم. MATLAB در تحلیل داده، مدلسازی، پردازش سیگنال و تصویری بسیار قوی است، در حالی که Python در زمینه کتابخانههای یادگیری عمیق مانند TensorFlow و PyTorch محبوبیت زیادی دارد. ترکیب این دو زبان، یک محیط فوقالعاده قدرتمند برای توسعه مدلهای هوش مصنوعی فراهم میکند.

با استفاده از دستور py در MATLAB میتوان توابع Python را فراخوانی کرد. همچنین امکان انتقال دادهها بین MATLAB و Python وجود دارد. این موضوع باعث شده بسیاری از متخصصان از MATLAB برای پیشپردازش دادهها و از Python برای آموزش مدلهای حجیم استفاده کنند.

مثال کاربردی: فرض کنید میخواهید یک مدل CNN بسیار بزرگ با PyTorch آموزش دهید، اما دادهها نیاز به فیلترگذاری، نرمالسازی و تحلیل دقیق دارند. شما میتوانید پیشپردازش را در MATLAB انجام دهید، خروجی را به Python منتقل کنید و سپس مدل را آموزش دهید.

در سایتهای هوش مصنوعی، ترکیب MATLAB و Python بهعنوان یک راهحل ایدهآل معرفی میشود، زیرا این ترکیب بهترین قابلیتهای دو دنیای مهندسی و یادگیری عمیق را کنار هم قرار میدهد.

استفاده از MATLAB برای آموزش مدلها و پیادهسازی در دنیای واقعی

MATLAB تنها برای آموزش مدلهای هوش مصنوعی ساخته نشده؛ بلکه برای پیادهسازی مدلها در دنیای واقعی نیز ابزارهای گستردهای ارائه میدهد. بسیاری از شرکتهای صنعتی و مهندسی از MATLAB برای ساخت مدل و سپس صادرات آن به سیستمهای واقعی استفاده میکنند.

MATLAB قابلیت تبدیل مدلها به زبانهای C، C++ و حتی HDL (برای FPGA) را دارد. این موضوع باعث میشود مدلهای هوش مصنوعی در محیطهای صنعتی، رباتیک، خودروهای خودران، تجهیزات پزشکی و دستگاههای Embedded قابل استفاده باشند.

مثال کاربردی: فرض کنید یک مدل تشخیص نقص قطعات صنعتی در MATLAB ساختهاید. پس از آموزش مدل، میتوانید با استفاده از MATLAB Coder مدل را به C تبدیل کرده و آن را روی یک ربات inspection واقعی اجرا کنید.

MATLAB همچنین ابزارهایی برای ادغام مدلها با سختافزارهای Arduino، Raspberry Pi، Nvidia Jetson و انواع پردازندهها دارد. سایتهای هوش مصنوعی MATLAB را یکی از مناسبترین ابزارها برای پیادهسازی مدل در مقیاس صنعتی میدانند.

این قابلیتها MATLAB را از یک نرمافزار آموزشی فراتر برده و آن را به یک پلتفرم کامل هوش مصنوعی تبدیل کرده است.

استفاده از مدلهای هوش مصنوعی MATLAB در پیادهسازیهای وب و موبایل

یکی از قابلیتهای جذاب MATLAB، امکان استفاده از مدلهای آموزشدیده در اپلیکیشنهای وب و موبایل است. امروزه سایتهای هوش مصنوعی و برنامههای موبایل به مدلهای یادگیری ماشین وابسته هستند و MATLAB ابزارهایی برای این یکپارچگی فراهم کرده است.

با کمک MATLAB Compiler و MATLAB Production Server میتوان مدلها را بهعنوان API یا سرویس تحت وب منتشر کرد. سپس این سرویسها بهراحتی در وبسایتها، اپلیکیشنهای موبایل، فروشگاههای آنلاین یا داشبوردهای مدیریتی استفاده میشوند.

مثال کاربردی: فرض کنید یک مدل طبقهبندی تصویر در MATLAB ساختهاید و میخواهید آن را در یک سایت هوش مصنوعی آنلاین استفاده کنید. کافی است مدل را به یک REST API تبدیل کنید. سپس سایت یا اپلیکیشن میتواند تصویر را ارسال کرده و نتیجه تحلیل هوش مصنوعی را دریافت کند.

علاوه بر این، MATLAB امکان تولید فایلهای standalone، exe، و حتی بستههای اندروید را نیز فراهم میکند. همین موضوع باعث میشود مدلهای هوش مصنوعی MATLAB در دستگاههای مختلف در دسترس باشند.

این ویژگی MATLAB را به یک ابزار کاربردی برای توسعهدهندگان وب، برنامهنویسان موبایل و طراحان سیستمهای هوشمند تبدیل کرده است.

بهترین منابع یادگیری MATLAB برای هوش مصنوعی

برای یادگیری MATLAB و استفاده از آن در حوزه هوش مصنوعی، منابع بسیار معتبر و حرفهای وجود دارد. سایت MathWorks، بهترین نقطه شروع است؛ زیرا آموزشهای رسمی، مثالهای کاربردی، دورههای رایگان و مستندات کامل ارائه میدهد. این سایت برای یادگیری مفاهیم پایه تا پیشرفته MATLAB و ساخت مدلهای AI بسیار مناسب است.

علاوه بر آن، سایتهای هوش مصنوعی مانند Coursera، Udemy و YouTube دورههای جامعی درباره یادگیری ماشین، یادگیری عمیق و پردازش تصویر در MATLAB ارائه میدهند. بسیاری از دانشگاهها نیز دورههای رایگان آنلاین در این زمینه دارند.

برای مثال، دوره “Deep Learning Onramp” از MathWorks یک دوره کوتاه و عالی برای شروع یادگیری شبکههای عصبی در MATLAB است.

کتابهای تخصصی مانند Machine Learning with MATLAB نیز برای یادگیری عمیقتر مناسب هستند.

همچنین فرومها و انجمنها مانند MATLAB Answers، StackOverflow و Reddit محلهای خوبی برای پرسش و پاسخ و یادگیری تجربی هستند.

اگر قصد دارید از هوش مصنوعی در پروژههای واقعی استفاده کنید، ترکیب این منابع با تمرین و اجرای پروژههای عملی بهترین روش یادگیری MATLAB است.

مقایسه MATLAB با ابزارهای دیگر AI (Python، R، TensorFlow، PyTorch)

برای انتخاب بهترین ابزار هوش مصنوعی، مقایسه MATLAB با زبانها و فریمورکهای دیگر ضروری است. MATLAB یک محیط کامل، یکپارچه و حرفهای است که در تحلیل داده، شبیهسازی و مدلسازی مهندسی فوقالعاده عمل میکند. بزرگترین مزیت آن، سادگی، رابط گرافیکی قوی و قابلیت اتصال به سختافزار است.

در مقابل، Python پایتون رایجترین زبان در دنیای هوش مصنوعی آنلاین و آفلاین است، زیرا کتابخانههای بسیار زیاد و متنباز مثل TensorFlow و PyTorch را ارائه میدهد. اگرچه توسعه در Python گاهی زمانبرتر است، اما انعطافپذیری بیشتری دارد.

R برای تحلیل آماری عالی است اما برای یادگیری عمیق بهاندازه MATLAB یا Python قوی نیست. TensorFlow و PyTorch مخصوص یادگیری عمیق طراحی شدهاند و برای مدلهای حجیم، بهخصوص روی GPU، انتخاب مناسبی هستند.

مثال کاربردی: اگر بخواهید موتور خودرو را شبیهسازی کنید و مدل هوش مصنوعی روی آن اعمال کنید، MATLAB بهترین گزینه است. اما اگر قصد دارید یک مدل NLP بسیار بزرگ بسازید، Python مناسبتر است.

بهطور کلی، MATLAB در حوزههای مهندسی، صنعتی و آکادمیک بهترین گزینه محسوب میشود، در حالی که Python برای پروژههای پژوهشی و مدلهای بزرگتر کاربرد بیشتری دارد.

آینده MATLAB در هوش مصنوعی؛ روندها، فرصتها و مسیر یادگیری

آیندگی MATLAB در هوش مصنوعی بسیار روشن است. با رشد سریع AI در صنعت، نیاز به ابزارهایی که بتوانند هم مدلسازی پیشرفته و هم پیادهسازی صنعتی را پوشش دهند افزایش یافته است. MATLAB دقیقاً چنین ابزاری است. این نرمافزار با قابلیتهای یادگیری ماشین، یادگیری عمیق، پردازش تصویر و سیگنال و همچنین اتصال به سختافزار، آیندهای قدرتمند در هوش مصنوعی دارد.

روندهایی مانند خودروهای خودران، اینترنت اشیا (IoT)، سیستمهای کنترل هوشمند، پردازش تصویر پزشکی و رباتیک، MATLAB را به انتخاب اول بسیاری از شرکتها تبدیل کرده است.

برای مثال، شرکتهای خودروسازی از MATLAB برای توسعه سیستمهای ADAS، تشخیص اشیاء و کنترل هوشمند استفاده میکنند. در صنایع پزشکی نیز از MATLAB برای تحلیل تصاویر MRI و ECG و توسعه سیستمهای تشخیص بیماری بهره گرفته میشود.

مسیر یادگیری MATLAB نیز بسیار ساده است: ابتدا یادگیری دستورات پایه، سپس تحلیل داده، یادگیری ماشین، یادگیری عمیق و در نهایت پروژههای عملی.

سایتهای هوش مصنوعی MATLAB را یکی از آیندهدارترین ابزارهای AI معرفی میکنند و انتظار میرود در سالهای آینده سهم بیشتری از پروژههای صنعتی و تحقیقاتی را به خود اختصاص دهد.

جمعبندی

MATLAB یکی از حرفهایترین ابزارها برای توسعه مدلهای هوش مصنوعی است و امکانات گستردهای در زمینه یادگیری ماشین، یادگیری عمیق، پردازش تصویر، پردازش سیگنال و مدلسازی پیشبینی ارائه میدهد. این نرمافزار بهخاطر جعبهابزارهای تخصصی، سرعت بالا، محیط یکپارچه و قابلیت اتصال به Python، C++، FPGA و انواع سختافزارها، هم در دانشگاهها و هم در صنعت بسیار محبوب است.

در این مقاله از پایه تا سطح حرفهای، نحوه استفاده از MATLAB برای تحلیل داده، ساخت مدلهای ML و DL، بهینهسازی، پیادهسازی در دنیای واقعی و حتی استفاده در وب و موبایل را بررسی کردیم.

اگر به دنبال استفاده عملی از هوش مصنوعی هستید؛ چه در سایت هوش مصنوعی آنلاین، چه در یک پروژه صنعتی یا پژوهشی، MATLAB ابزاری جامع و قابل اعتماد است. آینده این نرمافزار نیز با رشد AI بسیار روشن است و میتواند شما را در مسیر تبدیل شدن به یک متخصص هوش مصنوعی همراهی کند.

انتخاب MATLAB یعنی انتخاب دقت، سرعت و عملکرد حرفهای در دنیای هوش مصنوعی.