در حالی که سرعت تغییر نرمافزارها و نیاز به تحویل سریع پروژهها افزایش یافته است، سؤال مهمی مطرح است: آیا میتوان با هوش مصنوعی (AI)، برنامهنویسی را سادهتر و سریعتر کرد؟ مسما جواب بله است. اگرچه ممکن است برنامهنویسان نگران جایگزینی شغل خود با هوش مصنوعی شوند، اما در این مقاله به این نگرانی پاسخ خواهیم داد. وقتی مفهوم برنامه نویسی با هوش مصنوعی را متوجه شوید، استفاده از ابزارها و مدلهای هوش مصنوعی را بشناسید، خواهید دید AI صرفا یک ابزار کمکی است. کمکی برای کدنویسی، رفع خطا، تولید خودکار کد و تسهیل فرایند توسعه نرمافزار.

در نهایت شما پس از مطالعه این مقاله درک روشنی از امکانات واقعی آموزش و برنامه نویسی با AI و اینکه چگونه میتوانید در پروژههای خود آن را به کار بگیرید، خواهید داشت.

برنامهنویسی با هوش مصنوعی؛ چطور و چگونه؟

برنامهنویسی با هوش مصنوعی در واقع مجموعهای از روشها و ابزارهاست. این روش از الگوریتمهای یادگیری ماشین، مدلهای زبانی پیشرفته و سیستمهای تحلیل خودکار برای تولید، تکمیل یا بهبود کد استفاده میکند.

در این رویکرد، هوش مصنوعی نقش یک دستیار سرعتدهنده را ایفا میکند. دستیاری که در تحلیل مسئله، پیشنهاد ساختار مناسب، بازنویسی بخشهای ناکارآمد و حتی ایجاد تستهای اولیه نیز همراه توسعهدهنده است.

این تحول با پیشرفت مدلهای زبانی بزرگ (LLMها) و افزایش توان این مدلها در درک متن، تحلیل الگوها و تولید خروجیهای سازگار با قواعد برنامهنویسی فراهم شده است. این بستر جدید سبب شده تا توسعه نرمافزار از حالت صرفا کدنویسی دستی فاصله بگیرد. حالا کدنویسی به فرآیندی تبدیل شده که تعامل انسان و ماشین در آن نقشی ساختاری ایفا میکند.

نقش ابزارها در توسعه برنامه نویسی با هوش مصنوعی

ابزارهای امروزی قادرند خطاهای نحوی و منطقی را تشخیص دهند، تغییرات پیشنهادی ارائه کنند و حتی مستندات لازم برای بخشهای مختلف کد را بنویسند. در چنین فضایی، برنامهنویس میتواند به جای صرف زمان برای کارهای تکراری، تمرکز خود را بر طراحی معماری، تصمیمگیری فنی و حل مسئله بگذارد.

از سوی دیگر، این مفهوم تنها محدود به تولید کد نیست و موارد زیر را نیز شامل میشود.

- توانایی تحلیل دیتابیسها

- ارزیابی کیفیت کد

- پیشنهاد الگوریتمهای مناسب

- شناسایی الگوهای ناکارآمد

- تسهیل فرآیند یادگیری برای افراد مبتدی

بهطور کلی، برنامهنویسی با AI بستری فراهم میکند که در آن مهارت انسانی و قدرت محاسباتی هوش مصنوعی در کنار یکدیگر به ارتقای کیفیت، سرعت و دقت توسعه نرمافزار منجر میشوند.

کاربردها و نقشهای AI در چرخه توسعه نرمافزار

هوش مصنوعی در چرخه توسعه نرمافزار نقشی فراتر از یک ابزار کمکی دارد و مجموعهای از فعالیتهای متنوع را در فرآیند طراحی، توسعه، تست و نگهداری پشتیبانی میکند. قابلیتهای هوش مصنوعی که دقیقا در بخش قبل نام بردیم، موجب شده است بخش قابل توجهی از فعالیتهای زمانبر و تکراری، به صورت خودکار یا نیمهخودکار انجام شود.

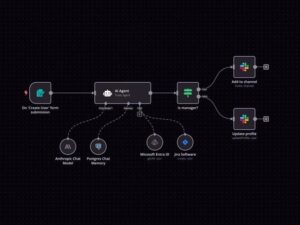

یکی از مهمترین نقشهای AI، حمایت از توسعهدهندگان در شیوههای مدرن DevOps و توسعه پیوسته (CI/CD) است. جایی که ابزارهای هوشمند به ارزیابی کیفیت کد، تحلیل ریسک و کاهش خطاهای احتمالی کمک میکنند.

علاوهبر این، AI توانایی استخراج مستندات از روی کد، تولید تستهای اولیه، پیشنهاد بهبود عملکرد و ارائه راهحلهای جایگزین را نیز دارد. تواناییای که باعث شده است برنامهنویسان بتوانند تمرکز خود را بر تصمیمهای معماری و طراحی کلان بگذارند.

کاربردهای AI همچنین در آموزش و یادگیری برنامهنویسی نمود ویژهای دارد. تحلیل لحظهای، توضیح خطاها و ارائه مثالهای ساده باعث شده افراد تازهکار بتوانند سریعتر وارد فرآیند توسعه شوند. این حوزهها و کاربردها را در بخشهای بعد این مقاله به طور کامل بررسی خواهیم کرد.

تکمیل و تولید خودکار کد

یکی از اولین و مهمترین حوزههایی که هوش مصنوعی در آن اثرگذاری چشمگیر داشته، تکمیل و تولید خودکار کد است. ابزارهای مبتنی بر مدلهای زبانی با تحلیل الگوهای موجود در مخازن عمومی و خصوصی کد، پیشنهادهای دقیقی برای ادامه خطوط کد ارائه میدهند. این ابزار حتی بخشهایی از کد را به صورت کامل تولید میکنند. این قابلیت مخصوصا در زبانهایی مانند Python، JavaScript و Java کاربرد فراوانی دارد، زیرا ساختار و الگوهای رایج آنها به خوبی توسط مدلها قابل شناسایی است.

علاوه بر تکمیل کد، برخی ابزارها قادرند قالبهای استاندارد برای توابع تکراری، ساختارهای API، اسکریپتهای اتوماسیون و حتی واحدهای تست را ایجاد کنند. این ویژگی باعث میشود برنامهنویس زمان کمتری را صرف ایجاد محتوای تکراری کند.

بازبینی کد، رفع خطا و تست خودکار

ابزارهای مبتنی بر هوش مصنوعی توانایی تحلیل الگوهای کدنویسی و شناسایی خطاهای منطقی و نحوی را دارند. این ابزارها با بررسی ساختار کد، مقایسه الگوهای رایج و مدلسازی رفتار احتمالی برنامه، خطاهای پنهان را میشناسند و پیشنهاد اصلاح میدهند. چنین قابلیتی، فرآیند بازبینی دستی را تسهیل میکند و سبب کاهش زمان رفع اشکالات در پروژههای بزرگ میشود.

در حوزه تست نرمافزار نیز AI قادر است موارد تست (Test Cases) را براساس ورودیهای موجود تولید کند. این موضوع مخصوصا در پروژههایی که نیاز به پوشش تست گسترده دارند اهمیت دارد. مدلهای هوش مصنوعی میتوانند مسیرهای اجرای مختلف را تحلیل و نقاط آسیبپذیر را شناسایی کنند. نتیجه این فرایند، افزایش دقت و کاهش احتمال بروز خطا در نسخههای نهایی است. علاوه بر این، برخی سیستمها امکان پیشبینی خطا براساس الگوهای پروژه را دارند. به این معنا که با بررسی تاریخچه کد، مشخص میکنند کدام بخشها بیشترین احتمال بروز خطا را دارند.

پشتیبانی از یادگیری و تسهیل ورود مبتدیان

هوش مصنوعی بهویژه برای افراد مبتدی بستری فراهم میسازد که یادگیری را سادهتر و قابلفهمتر میکند.

- توضیحات ساده: ابزارهای مبتنی بر AI قادرند بهطور لحظهای توضیحات مرتبط با کد، توصیف عملکرد توابع و رفع خطاهای رایج را ارائه دهند. در این حالت کاربر بدون نیاز به جستجوی مداوم در منابع مختلف میتواند دلیل بروز خطا و روش اصلاح آن را در همان لحظه بیاموزد.

- تولید مثال قابل فهم در آموزش: این ویژگی باعث میشود روند یادگیری ساختارمندتر پیش برود و فرد بتواند مفاهیم پیچیده را در قالب نمونههای کوچک و قابل اجرا تجربه کند.

- شخصیسازی مسیر یادگیری: ابزارهای هوشمند میتوانند مسیر یادگیری شخصیسازیشده پیشنهاد دهند؛ به این معنا که براساس عملکرد فرد، مرحله بعدی را تعیین میکنند.

- کاهش اضطراب یادگیری: کاربر میداند هر زمان به مشکل برخورد کند، سیستم او را راهنمایی میکند.

در مجموع، این فناوری با ترکیب تحلیل هوشمند، توضیحات ساده و مثالهای قابل اجرا، روند ورود افراد جدید به دنیای برنامهنویسی را شتاب میدهد.

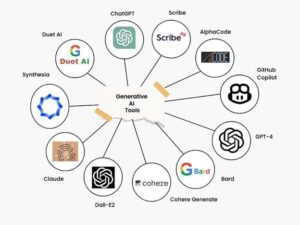

ابزارهای شاخص برای برنامهنویسی با AI در سال 2025

پیشرفتهای سالهای اخیر باعث شده ابزارهای مبتنی بر هوش مصنوعی در توسعه نرمافزار به یکی از ارکان اصلی فرایند کدنویسی تبدیل شوند. در سال 2025، ابزارهای متنوعی در دسترس توسعهدهندگان قرار دارد که هرکدام با تکیه بر مدلهای زبانی و سامانههای تحلیل هوشمند، وظایف مختلفی را انجام میدهند. از از تولید کد گرفته تا تست، مستندسازی و بهینهسازی.

انتخاب بهترین ابزار به نوع پروژه، زبان برنامهنویسی و جریان کاری تیم بستگی دارد. با این حال، چند گزینه به دلیل دقت بالا، گستره پشتیبانی و تجربه کاربری ساختاریافته، بیشتر از سایرین مورد استفاده قرار میگیرند.

از میان این ابزارها GitHub Copilot همچنان یکی از قدرتمندترین و پرکاربردترین دستیارهای کدنویسی محسوب میشود و در بسیاری از زبانها عملکردی پایدار ارائه میدهد. در کنار آن، ابزارهایی نظیر Windsurf، Codeium و Tabnine با تمرکز بر سرعت، حریم خصوصی و کاربری سازمانی جایگاه ویژهای پیدا کردهاند. در ادامه این بخش در مورد هر یک از این ابزارها بیشتر توضیح خواهیم داد.

GitHub Copilot

GitHub Copilot یکی از شناختهشدهترین ابزارهای برنامهنویسی با هوش مصنوعی است که با استفاده از مدلهای پیشرفته و بهروزشده GitHub و OpenAI، تجربه کدنویسی را ساختاریافتهتر و سریعتر میکند. نمونه کارآییهای این ابزار را در زیر آوردهایم.

- حدس ادامه خطوط کد

- پیشنهاد توابع کامل

- تولید قطعه کدهای قابلاجرا براساس توضیح متنی توسعهدهنده

Copilot با تحلیل الگوهای کد موجود در مخازن عمومی و دادههای آموزشی گسترده، پیشنهادهایی ارائه میدهد که معمولا با استانداردهای رایج زبانهای مختلف سازگار است.

مزایا و معایب Copilot

یکی از نقاط قوت Copilot، یکپارچگی مستقیم آن با محیطهای محبوبی مانند VS Code، JetBrains و GitHub Codespaces است. این ویژگی باعث میشود برنامهنویس بدون نیاز به ترک محیط کاری، بتواند از امکانات AI استفاده کند. علاوه بر تولید کد، Copilot در مستندسازی، ارائه توضیحات برای توابع و پیشنهاد تستهای اولیه نیز عملکرد قابلقبولی دارد.

البته استفاده از آن نیازمند دقت انسانی است؛ زیرا ممکن است مدل در برخی شرایط کدهایی پیشنهاد دهد که از نظر امنیتی یا عملکردی برای پروژه مناسب نباشند. با این حال، ترکیب قابلیت تکمیل هوشمند و تولید خودکار محتوا باعث شده Copilot یکی از پرکاربردترین ابزارهای برنامهنویسی در سال 2025 باقی بماند.

Windsurf ،Codeium و رقبا مانند Tabnine

در کنار Copilot، مجموعهای از ابزارهای قدرتمند نظیر Windsurf، Codeium و Tabnine جایگاهی استراتژیک در میان توسعهدهندگان پیدا کردهاند.

- Windsurf: بهعنوان یکی از جدیدترین دستیارهای هوش مصنوعی، به دلیل سرعت بالا در تحلیل کد و توانایی تفسیر فایلهای پیچیده پروژه، برای تیمهایی مناسب است که روی پروژههای چندزبانه کار میکنند. این ابزار با ارائه پیشنهادهای زمانی و تحلیل معماری، تجربه توسعه را به شکل قابلتوجهی روانتر میکند.

- Codeium: نیز با تمرکز بر ارائه خدمات رایگان و سازمانی، گزینهای مناسب برای تیمهایی است که بهدنبال ابزارهای مقرونبهصرفه با قابلیت حفظ حریم خصوصی هستند. Codeium از زبانهای متعددی پشتیبانی میکند و میتواند براساس ساختار پروژه پیشنهادهای دقیق ارائه دهد.

- Tabnine: با استفاده از مدلهای آموزشدیده اختصاصی و گزینههای اجرای لوکال، انتخابی مطلوب برای کسبوکارهایی است که حساسیت بالایی نسبت به امنیت داده دارند. این ابزار قادر است کدهای پیشنهادی را براساس استانداردهای پروژه و سبک سازمانی تنظیم کند.

در مجموع، این دستیارهای هوشمند با تکیه بر سرعت، دقت و یکپارچگی مؤثر با محیط توسعه، جایگزینهای ارزشمندی برای ابزارهای کلاسیک محسوب میشوند.

مزایا و فرصتهای برنامهنویسی با هوش مصنوعی

ورود هوش مصنوعی به حوزه توسعه نرمافزار مجموعهای از فرصتهای ساختاری را ایجاد کرده است. فرصتهایی که نهتنها به افزایش سرعت و دقت کمک میکنند، بلکه کیفیت نهایی محصول را نیز ارتقا میدهند.

یکی از مهمترین فرصتهای ایجادشده، افزایش سطح دسترسی به آموزش برنامهنویسی است. ابزارهای مبتنی بر AI میتوانند پیچیدهترین مفاهیم را با مثالهای ساده توضیح دهند و حتی مسیر یادگیری شخصیسازیشده ارائه کنند. این ویژگی باعث میشود افراد با سطح دانش متفاوت، بتوانند سریعتر وارد عرصه توسعه شوند و اشتباهات رایج را بهتر درک کنند.

در کنار این موارد، قابلیت تحلیل عملکرد، تست خودکار، تولید مستندات و پیشنهاد اصلاحات ساختاری، باعث میشود پروژههای نرمافزاری با کیفیت بیشتری به مرحله تولید برسند. برای تیمهای بزرگ نیز استفاده از ابزارهای AI میتواند همترازی اعضا را افزایش دهد و فرایند همکاری را تسهیل کند. در ادامه، مزایا و فرصتهای کلیدی این فناوری بهصورت ساختارمندتر بررسی میشود. در بخشهای بعد مهمترین مزیتهای استفاده از هوش مصنوعی در برنامهنویسی را میخوانید.

سرعت بیشتر، دقت بالاتر و کاهش خطا

یکی از برجستهترین مزایای برنامهنویسی با هوش مصنوعی، افزایش سرعت توسعه و کاهش خطاهای انسانی است.

- تحلیل کد در چند ثانیه: ابزارهای AI قادرند بخشهایی از کد را در چند ثانیه تحلیل کنند و پیشنهادهای بهینه ارائه دهند. موضوعی که در پروژههای بزرگ یا چندزبانه تأثیر قابلتوجهی دارد.

- دقت بالاتر در بررسی الگوهای پیچیده: این مدلها با آموزش گسترده، قادرند خطاهای احتمالی را پیش از اجرا تشخیص دهند و هشدارهای مبتنی بر ریسک ارائه کنند. چنین عملکردی بهویژه در بخشهایی مانند امنیت، مدیریت حافظه یا بهینهسازی عملکرد اهمیت دارد.

- کاهش خطاهای سطحی: AI باعث میشود خروجی کد استانداردتر و پایدارتر باشد. البته این مزیت زمانی به بیشترین اثر میرسد که توسعهدهنده همچنان نقش بررسیکننده نهایی را ایفا کند؛ زیرا مدلها در برخی موارد ممکن است صرفاً براساس الگوها پیشنهاد دهند.

در مجموع، استفاده از هوش مصنوعی موجب ایجاد جریان توسعهای دقیقتر، سریعتر و سازگارتر با نیازهای پروژههای مدرن میشود.

یادگیری سریعتر برای مبتدیان و افزایش بهرهوری برای متخصصان

هوش مصنوعی نقش مهمی در تسهیل یادگیری برنامهنویسی دارد. برای افراد مبتدی، ابزارهای AI مانند یک مربی هوشمند عمل میکنند که در هر لحظه میتوانند خطاها را توضیح دهند، مثالهای ساده ارائه کنند و مسیر یادگیری مرحلهبهمرحله پیشنهاد دهند. چنین رویکردی استرس ناشی از آغاز یادگیری را کاهش میدهد و اجازه میدهد کاربر مفاهیم پایه را با سرعت بیشتری درک کند.

برای توسعهدهندگان حرفهای نیز این ابزارها فرصت افزایش بهرهوری ایجاد میکنند. مدلهای هوشمند میتوانند مستندات طولانی را خلاصه کنند، ساختارها را تحلیل کنند و پیشنهادهای بهینهسازی ارائه دهند. این مزیت در پروژههایی که شامل ماژولهای متعدد یا وابستگیهای پیچیده هستند اهمیت بیشتری پیدا میکند.

در کنار این موارد، AI میتواند نقش یک مشاور فنی لحظهای را ایفا کند. به این معنا که توسعهدهنده هنگام مواجهه با مسئله پیچیده، توضیح متنی کوتاهی ارائه میدهد و ابزار پاسخهایی مبتنی بر بهترین شیوهها پیشنهاد میکند. چنین تعاملی زمان حل مسئله را کاهش میدهد و تمرکز ذهنی را افزایش میدهد. حاصل این فرآیند، ترکیبی از یادگیری مستمر و تولید کد با کیفیت بالا است.

پشتیبانی از معماری، طراحی و تصمیمگیری در پروژههای بزرگ

در پروژههای بزرگ و سیستمهای پیچیده، تصمیمگیری معماری یکی از حساسترین مراحل است. ابزارهای هوش مصنوعی با تحلیل ساختار فعلی پروژه، وابستگیها، حجم داده و جریان اجرا، پیشنهادهایی برای طراحی بهتر ارائه میدهند. این تحلیلها کمک میکند تیم توسعه از تصمیمهایی که ممکن است در آینده باعث ایجاد گلوگاه شوند، جلوگیری کند.

AI با پردازش مستندات معماری موجود، ناسازگاریهای احتمالی بین ماژولها را تشخیص میدهد. شناسایی نقاطی که نیاز به تقسیم، ادغام یا بهینهسازی دارند، باعث میشود توسعهدهنده دید دقیقتری نسبت به ساختار پروژه پیدا کند. در معماریهای مبتنی بر سرویس، ابزارهای AI میتوانند الگوهای ارتباطی و عملکردی را تحلیل کنند و مسیرهای بهینهتر پیشنهاد دهند.

همچنین بسیاری از مدلها توانایی شبیهسازی رفتار احتمالی سیستم را دارند؛ یعنی میتوانند پیشبینی کنند یک تغییر در کدام بخشها اثر خواهد گذاشت. این ویژگی هنگام افزودن قابلیتهای جدید یا تغییر در ساختارهای اصلی، ریسک تصمیمگیری را کاهش میدهد.

امنیت، ریسکها و چالشهای استفاده از هوش مصنوعی در برنامهنویسی

با وجود مزایای گسترده هوش مصنوعی در چرخه توسعه نرمافزار، استفاده از آن بدون چالش نیست. برخی از مهمترین ریسکها و چالشهای برنامهنویسی با هوش مصنوعی را در زیر آوردهایم.

- امنیت: مدلهای هوش مصنوعی معمولا بر اساس دادههای گسترده آموزش داده میشوند و اگر دادههای آموزشی شامل الگوهای ناامن یا کدهای آسیبپذیر باشد، ممکن است همان اشتباهات را در خروجی تکرار کنند. به همین دلیل توسعهدهندگان باید همیشه خروجی AI را بررسی و از آن بهعنوان یک مرجع کمکی استفاده کنند، نه یک منبع قطعی.

- نشت اطلاعات حساس: اگر ابزار هوش مصنوعی در فضای ابری کار کند یا دادههای پروژه در اختیار مدل قرار گیرد، احتمال انتقال غیرعمدی اطلاعات وجود دارد. به همین دلیل رعایت سیاستهای محرمانگی، استفاده از نسخههای لوکال یا رمزنگاریشده و محدود کردن دادههای ورودی ضروری است.

- وابستگی بیش از حد به ابزارها: برنامهنویسانی که بهجای یادگیری اصول، صرفا بر اتوکدینگ یا تکمیل خودکار تکیه میکنند، ممکن است درک عمیق خود از معماری، الگوریتمها و منطق برنامهنویسی را از دست بدهند. این مشکل در بلندمدت منجر به کاهش مهارت فردی و افزایش احتمال اشتباه در پروژههای پیچیده میشود.

علاوه بر این، مشکلاتی مانند سوگیری مدلها، پیشنهادهای اشتباه، تداخل با استانداردهای تیمی، مصرف منابع بالا و عدم سازگاری با برخی فناوریها نیز جزو چالشهای رایج هستند.

آینده برنامهنویسی با هوش مصنوعی در سالهای پیش رو

آینده برنامهنویسی با هوش مصنوعی مسیری روشن، تحولآفرین و البته همراه با چالشهای جدید خواهد بود. در سالهای پیش رو، انتظار میرود نقش AI از یک «دستیار هوشمند» فراتر رود و به بخشی یکپارچه و ضروری از فرایند توسعه نرمافزار تبدیل شود.

مدلهای زبانی در نسلهای آینده توانایی درک معماری سیستمها، تحلیل نیازمندیها و تولید کدهای سطح بالا تا سطح سیستمعامل را با دقتی بیسابقه خواهند داشت. همین موضوع باعث میشود زمان توسعه کاهش یابد و تیمها بتوانند بهجای تمرکز بر کارهای تکراری، روی خلاقیت، طراحی و تصمیمهای استراتژیک تمرکز کنند.

هوش مصنوعی در آینده چه کاری برای برنامه نویسان خواهد کرد؟

یکی از روندهای مهم آینده، خودکارسازی گسترده فرایندها (Autonomous Development) است. این عبارت یعنی هوش مصنوعی نهتنها باید بخشی از کد را تولید کند، بلکه باید بتواند بهصورت خودمختار ماژولهایی را تست، بهینهسازی و اصلاح کند. این سطح از خودکارسازی احتمالا نرمافزارهایی به وجود میآورد که خود را ترمیم میکنند و با تغییر نیازها یا شرایط اجرا، بهطور خودکار سازگار میشوند.

در کنار این تحولات، انتظار میرود تعامل انسان و AI شکل جدیدی پیدا کند. توسعهدهندگان بیشتر شبیه معمارانی خواهند بود که بهجای نوشتن تمام جزئیات، با بیان هدف و منطق کلان، مسیر را برای سیستمهای هوشمند مشخص میکنند.

با این حال، آینده بدون چالش نیست. مسائل امنیتی، نظارت بر کیفیت، قوانین حریم خصوصی و نیاز به مهارتهای جدید برای مدیریت سیستمهای هوشمند همچنان اهمیت خود را حفظ خواهند کرد. در مجموع، آینده برنامهنویسی با AI ترکیبی از سرعت بیشتر، کیفیت بالاتر و نقش انسانی متمرکز بر خلاقیت و استراتژی خواهد بود.

در آخر؛ پیشرفت برنامه نویسی با هوش مصنوعی در گروه یادگیری

برنامهنویسی با هوش مصنوعی اکنون به مرحلهای رسیده است که نهتنها روند توسعه نرمافزار را متحول میکند، بلکه ساختار نقشهای تخصصی در این حوزه را نیز دگرگون میسازد. در این مقاله، مسیر ورود به این حوزه، ابزارهای اصلی، کاربردها، مزایا و چالشها، روشهای یادگیری و آینده این فناوری را آموختید.

حاصل این مسیر دانشی است که به شما به عنوان برنامهنویس کمک میکند بدانید چگونه از AI برای افزایش دقت، سرعت و کیفیت پروژههای خود بهره ببرید. در عین حال نیز نقش انسانی خود را در سطح طراحی و تصمیمسازی حفظ کنید.

حالا و امروزه دیگر اهمیت آموزش برنامهنویسی با AI بیش از هر زمان دیگری احساس میشود؛ زیرا افرادی که اکنون یادگیری را آغاز کنند، در سالهای آینده جایگاهی رقابتیتر خواهند داشت. از سوی دیگر، آشنایی با ابزارهای برنامهنویسی با هوش مصنوعی نهتنها موجب صرفهجویی در زمان میشود، بلکه فرصتهای تازهای برای نوآوری فراهم میکند. پس شاید بهتر باشد همین امروز به سراغ ارتقا خود در زمینه برنامهنویسی با هوش مصنوعی بروید تا از موج سوم انقلابهای جهانی عقب نمانید.